Immagina un esercito di piccoli esploratori invisibili che, ogni giorno, viaggiano attraverso miliardi di pagine web, alla ricerca di contenuti da scoprire, catalogare e rendere disponibili agli utenti di tutto il mondo. Questi esploratori sono i Googlebot, i veri protagonisti dietro le quinte dell’indicizzazione su Google. Ma cosa sono esattamente? Come operano? E, ancora più importante, come puoi ottimizzare il tuo sito per farti trovare da loro facilmente, evitando nel frattempo quegli errori SEO che rischiano di vanificare tutti i tuoi sforzi?

Googlebot è il nome dato al crawler ufficiale di Google, un software progettato per visitare, leggere e interpretare i contenuti delle pagine web. Il suo compito principale è quello di esplorare nuovi contenuti o aggiornamenti, inserirli nell’enorme indice di Google e permettere che vengano trovati dagli utenti quando effettuano una ricerca. Pensalo come un ispettore instancabile, sempre a caccia di informazioni fresche e utili per alimentare il motore di ricerca più potente al mondo.

Capire come funziona il crawl googlebot oggi è diventato fondamentale per chiunque voglia ottenere visibilità online. Anche il contenuto più brillante può restare invisibile se il crawler non riesce a scoprirlo, interpretarlo correttamente o, peggio ancora, se viene bloccato da errori tecnici non rilevati in tempo. Una configurazione sbagliata del file robots.txt, problemi di accessibilità mobile o errori server ripetuti possono sabotare anche la miglior strategia SEO.

In questo articolo ti accompagnerò in un viaggio completo per scoprire cos’è Googlebot, come funziona il processo di crawling, quali sono le differenze operative tra la versione desktop e quella mobile, e come puoi preparare il tuo sito per rendere ogni scansione una porta aperta verso un miglior posizionamento. Esploreremo insieme anche le tecniche per prevenire errori SEO, spesso trascurati ma in realtà capaci di compromettere pesantemente l’indicizzazione e la visibilità delle tue pagine.

Che tu sia un principiante curioso o un esperto SEO in cerca di approfondimenti, questo percorso ti darà strumenti pratici e una nuova consapevolezza su come gestire il rapporto con i crawler Google, monitorare il loro comportamento, correggere tempestivamente eventuali criticità e costruire basi solide per una crescita organica continua.

Se vuoi davvero capire come Google vede il tuo sito e come aiutarlo a scoprire il meglio dei tuoi contenuti, sei nel posto giusto.

Cos’è Googlebot: il robot di Google che esplora il web

Quando si parla di SEO, spesso ci si concentra su contenuti, parole chiave e link building. Ma dietro ogni sito ben posizionato, c’è un protagonista silenzioso che lavora nell’ombra: il Googlebot. Questo piccolo robot digitale è il cuore pulsante del sistema di indicizzazione di Google. Senza di lui, nessun contenuto potrebbe mai raggiungere gli occhi degli utenti.

Googlebot è un software crawler, conosciuto anche come google robot, progettato per navigare attraverso il web, esaminando siti, pagine, immagini e file. Ogni volta che pubblichi un nuovo contenuto, è proprio Googlebot a scoprirlo, leggerlo e valutarlo. Non si tratta di un processo casuale: Googlebot segue regole precise, rispetta i file robots.txt, analizza i segnali delle tue pagine e determina se vale la pena indicizzare i tuoi contenuti.

Immagina di gestire un sito di e-commerce. Hai caricato una nuova collezione di prodotti, ma se Googlebot non riesce a scansionare le nuove pagine, gli utenti non le troveranno mai su Google. Ecco perché è fondamentale conoscere come funziona il crawl googlebot: senza una corretta configurazione, rischi di restare invisibile.

Nella sua attività quotidiana, Googlebot si comporta come un visitatore modello: scarica le pagine, interpreta il codice HTML, analizza i collegamenti e invia tutto ciò che trova ai server di Google. Questo processo è chiamato crawling, ed è il primo passo verso l’indicizzazione.

È importante sapere che oggi Googlebot smartphone è diventato la versione principale che Google utilizza per esplorare i siti, a conferma dell’importanza crescente della navigazione mobile. Se il tuo sito non è mobile-friendly, Googlebot potrebbe avere difficoltà a scansionarlo correttamente.

In breve, capire cos’è Googlebot significa comprendere come Google vede il tuo sito. E padroneggiare questa conoscenza è il primo passo per ottimizzare davvero la tua presenza online.

Che cos’è un Googlebot: definizione e ruolo nel crawling

Googlebot è, in parole semplici, un crawler automatico, un software robotizzato incaricato di esplorare e catalogare i contenuti presenti online. Ma definirlo solo così sarebbe riduttivo: Googlebot è la connessione diretta tra il tuo sito web e il motore di ricerca più usato al mondo.

Quando pubblichi una nuova pagina o aggiorni un contenuto, è il google bot che si occupa di intercettarlo. Il suo compito primario è raccogliere informazioni aggiornate, per arricchire l’indice di Google. Più il tuo sito è strutturato in modo chiaro e pulito, più sarà facile per Googlebot eseguire il suo lavoro.

Durante il crawl googlebot, il robot invia richieste HTTP ai server, analizza il codice, interpreta eventuali reindirizzamenti, segue i link interni e raccoglie tutto ciò che può essere utile. Ogni pezzo di contenuto, ogni tag, ogni meta description diventa materiale prezioso per l’indicizzazione.

Un aspetto interessante è che Googlebot non scansiona tutto subito. Esiste un concetto chiamato “crawl budget“, ovvero una quantità limitata di risorse che Google dedica al tuo sito. Se il tuo sito è lento, disordinato o presenta errori di accessibilità, Googlebot potrebbe scansionare meno pagine di quante vorresti.

Sapere come dialogare con Googlebot significa anche configurare correttamente il file robots.txt, utilizzare al meglio le direttive nofollow, e ottimizzare la struttura dei link interni. Solo così riuscirai a guidare il crawler attraverso le tue pagine più importanti.

In sintesi, Googlebot è il ponte tra i tuoi contenuti e gli utenti finali. Trattarlo bene significa aumentare le tue possibilità di emergere nella giungla della concorrenza online.

Perché il Googlebot è fondamentale per l’indicizzazione dei siti

Molti pensano che basti pubblicare un contenuto online perché venga trovato da Google. La realtà è molto diversa. Senza il passaggio del Googlebot, un contenuto non esiste agli occhi del motore di ricerca. È il crawler di Google che decide se una pagina merita di essere indicizzata, e di conseguenza visibile agli utenti.

Ogni volta che Googlebot visita il tuo sito, raccoglie informazioni fondamentali: la qualità dei testi, la struttura dei link, la velocità di caricamento, la presenza di errori tecnici. Ogni elemento che incontra contribuisce a formare l’immagine che Google si fa del tuo progetto online.

Se Googlebot trova pagine orfane (non collegate da nessun’altra), contenuti duplicati o errori server, potresti compromettere gravemente la tua indicizzazione. Ecco perché è essenziale facilitare il lavoro del crawler google: guidarlo, dargli accesso ai contenuti giusti, ridurre gli ostacoli tecnici.

Inoltre, Google utilizza diverse tipologie di crawler specializzati: esistono google crawlers dedicati a immagini, video, news. Ogni ramo lavora in sinergia per creare una mappa dettagliata del tuo sito.

Ottimizzare per il googlebot smartphone è oggi una priorità. Con la crescita del mobile browsing, Google preferisce la versione mobile di un sito per l’indicizzazione primaria. Se la versione mobile è lenta, piena di errori o differente da quella desktop, la tua SEO può subire gravi penalizzazioni.

In conclusione, Googlebot è il tuo interlocutore invisibile. Più rendi facile il suo lavoro, maggiori saranno le tue chance di essere trovato, apprezzato e premiato da Google.

Le diverse tipologie di Googlebot: desktop, smartphone e non solo

Quando pensiamo a Googlebot, spesso immaginiamo un unico crawler che esplora i siti. In realtà, Google ha sviluppato diverse versioni specializzate del suo bot per rispondere alle nuove esigenze del web. Capire queste differenze può fare la differenza tra un sito ottimizzato e uno invisibile.

La distinzione principale riguarda il Googlebot Desktop e il Googlebot Smartphone. Oggi, la navigazione mobile ha superato quella da desktop, e Google ha risposto a questa rivoluzione spostando il suo focus sulla versione mobile dei siti. Questo significa che il comportamento del Googlebot Smartphone è diventato determinante per l’indicizzazione.

Ma non è tutto. Esistono anche google crawlers dedicati a specifiche tipologie di contenuto: immagini, video, news e molto altro. Ogni versione ha regole leggermente diverse di scansione e indicizzazione. Se vuoi davvero dominare la SEO moderna, devi conoscere queste varianti e preparare il tuo sito per tutte.

Anche strumenti come il file robots.txt e i meta tag devono essere configurati pensando a quale Googlebot vuoi attirare o limitare. Ignorare queste differenze può portare a una scarsa indicizzazione delle tue risorse più preziose.

In breve, Googlebot non è uno solo. È una famiglia di crawler, ognuno con un compito preciso, e saperlo sfruttare ti offre un vantaggio enorme nella guerra per il traffico organico.

Differenze tra Googlebot Desktop e Googlebot Smartphone

Fino a pochi anni fa, il Googlebot Desktop era il principale esploratore dei contenuti web. Visitava i siti come se fosse un utente da computer fisso, analizzando testi, immagini e link. Tuttavia, con l’esplosione dell’uso degli smartphone, Google ha dovuto adattarsi rapidamente. Nasce così il protagonista moderno: il Googlebot Smartphone.

Googlebot Smartphone simula un utente mobile. Questo significa che scansiona il sito valutando velocità, responsività, usabilità mobile. Se la versione mobile del tuo sito è lenta, incompleta o difficile da navigare, Googlebot lo rileverà immediatamente, influenzando negativamente il ranking.

Una differenza fondamentale è che oggi, con il cosiddetto mobile-first indexing, Google utilizza principalmente i dati raccolti dal Googlebot Smartphone per determinare il posizionamento di un sito. Se non ottimizzi prima per il mobile, stai giocando una partita persa in partenza.

Il crawl googlebot cambia quindi leggermente in base al dispositivo simulato: il Googlebot Desktop potrebbe ignorare alcuni aspetti responsive che invece sono cruciali per il bot mobile.

Consiglio pratico: usa strumenti come il “Test di compatibilità mobile” di Google per verificare esattamente cosa vede il Googlebot Smartphone. Una navigazione fluida su mobile è oggi il miglior regalo che puoi fare alla tua SEO.

Altri Googlebot specializzati: immagini, video, news

Oltre ai crawler standard, Google ha creato robot Google specializzati per diversi tipi di contenuto. Questi Googlebots settoriali lavorano per assicurare che ogni risorsa sia adeguatamente indicizzata e resa disponibile nelle ricerche tematiche.

Googlebot Images si occupa di scansionare le immagini dei siti web. Ottimizzare il testo alternativo (alt text), i nomi dei file e il contesto delle immagini è fondamentale per attrarre questo crawler. Un’immagine ottimizzata può portare un traffico organico sorprendente tramite Google Images.

Googlebot Video è responsabile della scansione dei contenuti video. Se pubblichi video sul tuo sito, assicurati di usare markup strutturati (schema.org/videoObject) per aiutare il crawler a capire il contenuto. Questo migliora anche le possibilità di comparire nelle sezioni video delle SERP.

Googlebot News, invece, esplora contenuti freschi e aggiornati, in particolare quelli pubblicati da siti registrati su Google News Publisher Center. Essere visibili su Google News significa raggiungere milioni di utenti in cerca di aggiornamenti quotidiani.

Esistono poi altri google robots minori, dedicati ad API, Shopping, Ads. Anche se meno noti, possono influire indirettamente sulla qualità complessiva della tua indicizzazione.

Conclusione pratica: ogni contenuto che pubblichi può essere raggiunto da un crawler Google diverso. Preparare ogni sezione del tuo sito pensando a chi la scansionerà ti permette di ottenere una copertura organica completa e duratura.

Come Googlebot esegue il crawl e indicizza le tue pagine

Molti pensano che, una volta messo online un sito, Google se ne accorga automaticamente. In realtà, è il Googlebot che deve prima scoprirlo, esplorarlo e valutarlo. Questo processo si chiama crawling ed è il primo passo cruciale verso la visibilità online.

Quando un nuovo sito o una nuova pagina viene pubblicata, il google crawler riceve dei segnali che lo avvisano della novità: può trattarsi di link da altri siti, sitemap aggiornate o semplicemente l’attività naturale del crawl googlebot. A quel punto, Googlebot visita l’URL, interpreta il codice HTML, analizza immagini, file CSS e JavaScript, e cerca di capire l’importanza del contenuto.

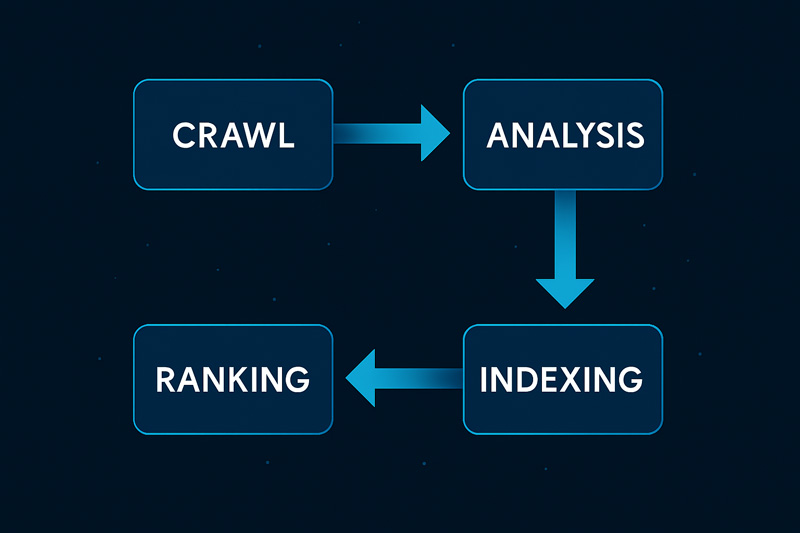

Per visualizzare meglio il funzionamento del crawling e della successiva indicizzazione da parte di Googlebot, osserviamo il processo illustrato nel diagramma seguente.

Non tutte le pagine vengono trattate allo stesso modo. Se un sito è lento, pieno di errori o poco autorevole, Googlebot potrebbe decidere di non esplorarlo in profondità. Al contrario, un sito ottimizzato, veloce e con contenuti di qualità riceverà più attenzione.

Un fattore critico è il crawl budget: ogni sito ha una quantità limitata di risorse che Googlebot dedica alla scansione. Se sprechi questo budget con pagine inutili o errori server, il tuo sito rischia di restare parzialmente invisibile.

Capire il funzionamento del crawling ti permette di costruire un’architettura di sito più efficace, migliorare la velocità di caricamento e favorire una scoperta più rapida dei nuovi contenuti.

Googlebot smartphone, oggi più rilevante che mai, effettua il crawling mobile-first. Se la tua versione mobile è lenta o disfunzionale, il crawling sarà limitato e penalizzante.

In sintesi, il crawling è la porta d’ingresso al successo SEO. Se vuoi che il tuo sito emerga, devi renderlo attraente e accessibile per il bot google fin dal primo istante.

Come funziona il processo di crawling di Googlebot

Il processo di crawling inizia con un elenco di URL che Googlebot deve visitare. Questo elenco può derivare da sitemap XML, collegamenti interni, link esterni o richieste di scansione tramite Search Console. Una volta ricevuto l’input, il google crawler programma l’esplorazione tenendo conto della priorità e delle risorse disponibili.

Quando Googlebot visita una pagina, non si limita a leggerla superficialmente. Analizza il contenuto principale, individua eventuali aggiornamenti rispetto a versioni precedenti, segue i link per scoprire nuove pagine e valuta segnali importanti come il nofollow, i canonicals e il file robots.txt.

Il crawl googlebot tiene anche conto di elementi tecnici come il tempo di risposta del server, la qualità del codice HTML, e la presenza di errori 404 o 500. Un server instabile o un sito pieno di errori può rallentare o addirittura bloccare il processo di crawling.

Una volta che la pagina è stata scansionata, Googlebot la invia ai sistemi di Google per ulteriori analisi e, se tutto è conforme agli standard di qualità, avvia la fase successiva: l’indicizzazione.

Per migliorare la capacità di Googlebot di scansionare il tuo sito, devi:

- Tenere aggiornate le sitemap.

- Ridurre il numero di redirect.

- Utilizzare strutture di link interne solide.

Un buon crawling è come una visita guidata ben organizzata: più rendi semplice il percorso, più aumenti le possibilità che tutte le tue pagine vengano scoperte e indicizzate correttamente.

Dall’esplorazione all’indice: come Googlebot valuta i tuoi contenuti

Una volta terminato il crawl, il lavoro di Googlebot non è finito. I dati raccolti vengono trasmessi ai sistemi di Google, dove avviene un’ulteriore fase critica: l’indicizzazione. Non tutto ciò che Googlebot scopre viene automaticamente mostrato nei risultati di ricerca.

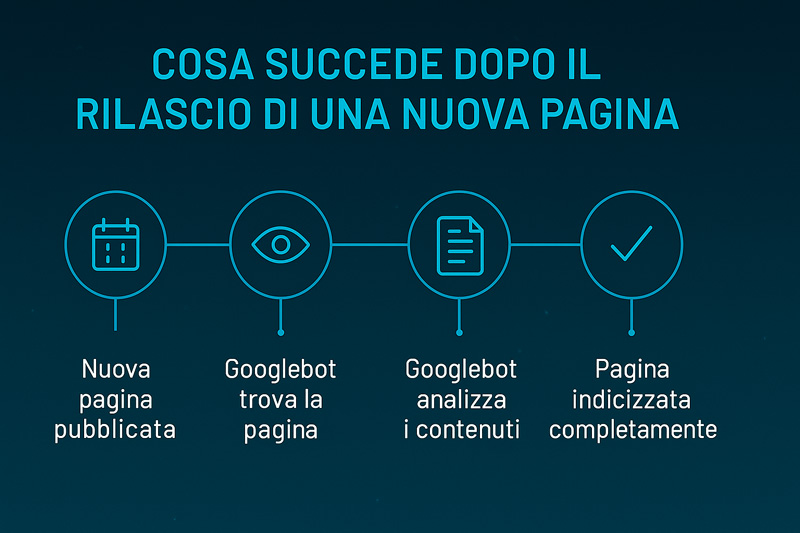

Per comprendere meglio le fasi che portano una nuova pagina dalla scoperta all’indicizzazione completa, osserviamo questa timeline visiva dedicata al processo di Googlebot.

Il contenuto viene analizzato in base a numerosi criteri: rilevanza, originalità, qualità, sicurezza e struttura. Se il sistema rileva che la pagina è di scarso valore, duplicata o priva di contenuti utili, potrebbe decidere di non indicizzarla affatto.

Googlebot smartphone ha un ruolo centrale in questo processo, valutando anche come i contenuti si adattano ai dispositivi mobili. Se la versione mobile è povera di contenuti rispetto a quella desktop, Google potrebbe scegliere di ignorare la pagina.

Durante l’indicizzazione, Google considera anche l’uso corretto delle parole chiave, i segnali strutturali come i tag H1, H2, i dati strutturati e la coerenza semantica. Ottimizzare tutti questi elementi rende il tuo sito più “appetibile” per il motore di ricerca.

Ricorda: essere scansionati da Googlebot non garantisce l’inserimento nell’indice.

Serve qualità, chiarezza, e valore autentico per emergere.

In definitiva, il successo su Google dipende dalla tua capacità di far innamorare prima Googlebot e poi l’algoritmo di ranking.

Costruisci per l’utente, ma apri la strada a Googlebot.

Come ottimizzare il tuo sito per Googlebot: strategie SEO concrete

Ottimizzare il tuo sito per Googlebot non è un’opzione, è una necessità. Se vuoi che il tuo sito emerga nei risultati di ricerca, devi rendere il lavoro del crawler di Google il più semplice ed efficace possibile. Fortunatamente, esistono tecniche collaudate per farlo.

Il primo passo è garantire che tutte le tue pagine siano accessibili. Questo significa avere una struttura di link interna chiara, utilizzare sitemap XML aggiornate e minimizzare i percorsi complicati. Se Googlebot non riesce a trovare una pagina, per Google quella pagina non esiste.

Un altro elemento cruciale riguarda la velocità del sito. Un sito lento non solo penalizza l’esperienza utente, ma limita anche il crawl googlebot. Il crawler preferisce siti veloci e reattivi: ogni secondo di caricamento in più può ridurre il numero di pagine esplorate.

Ottimizzare per il mobile è oggi imprescindibile. Ricorda che il Googlebot Smartphone è quello primario: se il tuo sito mobile è lento o mal configurato, perderai terreno nella corsa SEO. Un design responsive, tempi di caricamento rapidi e facilità di navigazione sono indispensabili.

Non dimenticare l’importanza del file robots.txt e delle meta direttive. Usa il file robots.txt per guidare Googlebot verso i contenuti più importanti, ma evita blocchi inutili che potrebbero limitare l’indicizzazione.

Infine, cura i dettagli: titoli chiari, descrizioni coerenti, contenuti originali. Ogni piccolo miglioramento facilita il lavoro del crawler Google e rafforza la tua presenza online.

Ottimizzare per Googlebot non è difficile, ma richiede attenzione.

Chi capisce come aiutare il crawler vince la battaglia della visibilità.

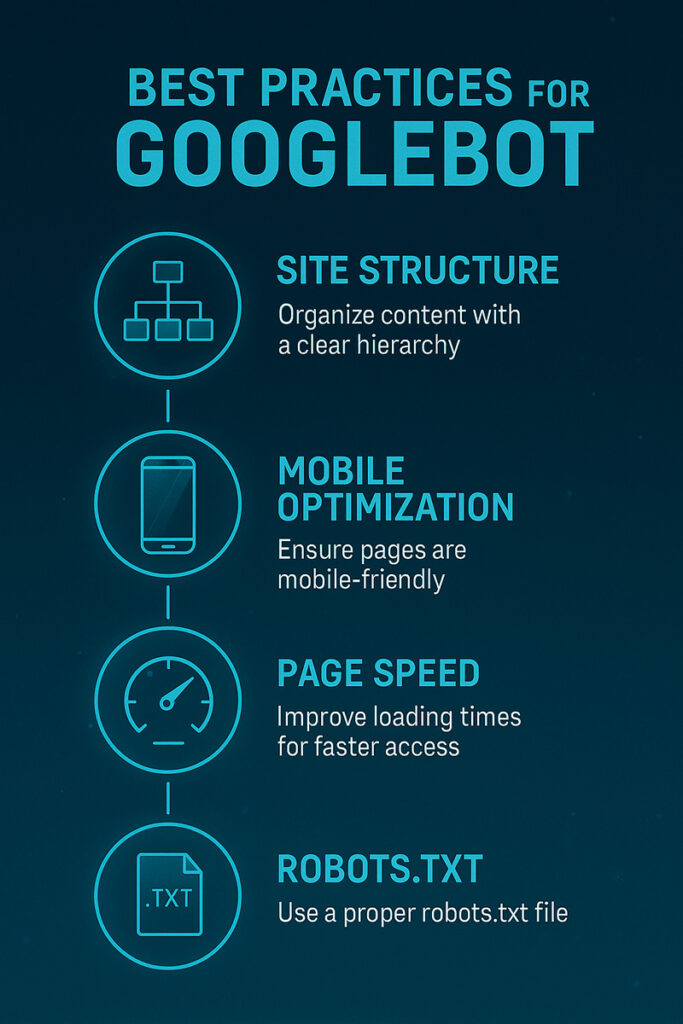

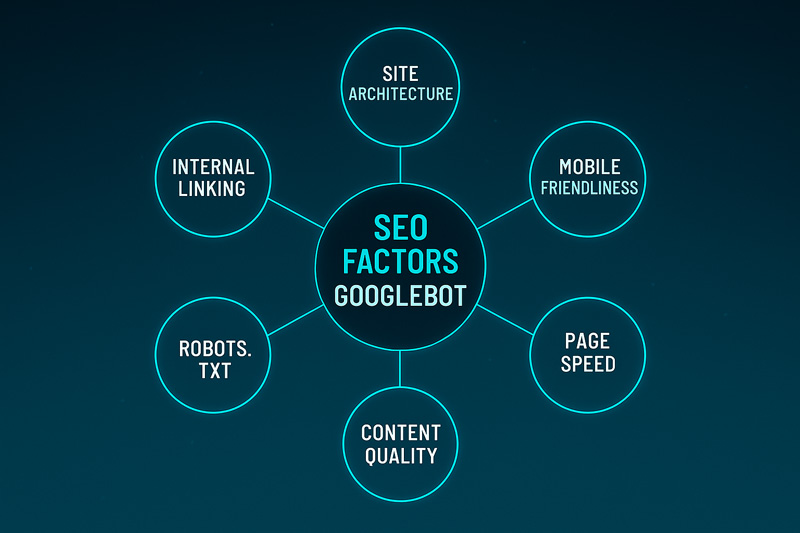

Per sintetizzare le migliori strategie SEO utili a favorire la scansione e l’indicizzazione da parte di Googlebot, ecco una pratica infografica.

Best practices per rendere il tuo sito facilmente scansionabile

Vuoi che Googlebot trovi, capisca e ami il tuo sito? Segui queste best practices semplici ma potentissime.

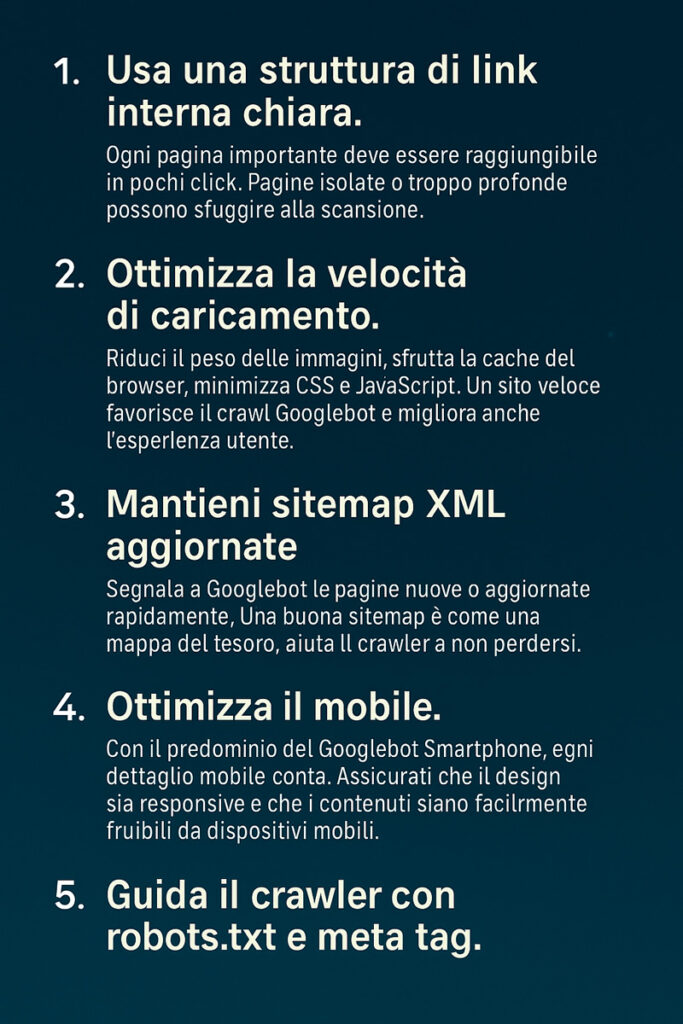

1. Usa una struttura di link interna chiara.

Ogni pagina importante deve essere raggiungibile in pochi click. Pagine isolate o troppo profonde possono sfuggire alla scansione.

2. Ottimizza la velocità di caricamento.

Riduci il peso delle immagini, sfrutta la cache del browser, minimizza CSS e JavaScript. Un sito veloce favorisce il crawl googlebot e migliora anche l’esperienza utente.

3. Mantieni sitemap XML aggiornate.

Segnala a Googlebot le pagine nuove o aggiornate rapidamente. Una buona sitemap è come una mappa del tesoro: aiuta il crawler a non perdersi.

4. Ottimizza il mobile.

Con il predominio del Googlebot Smartphone, ogni dettaglio mobile conta. Assicurati che il design sia responsive e che i contenuti siano facilmente fruibili da dispositivi mobili.

5. Guida il crawler con robots.txt e meta tag.

Usa robots.txt per escludere aree non importanti (es. pagine amministrative) e i meta tag noindex per evitare duplicati. Il controllo è tuo: devi solo usarlo con intelligenza.

Ecco una checklist visiva che riassume le migliori pratiche SEO per aiutare Googlebot a scansionare e indicizzare il tuo sito senza ostacoli.

Implementando queste pratiche, trasformi il tuo sito in un habitat perfetto per i google crawlers, massimizzando l’efficienza del crawling e migliorando il tuo posizionamento organico.

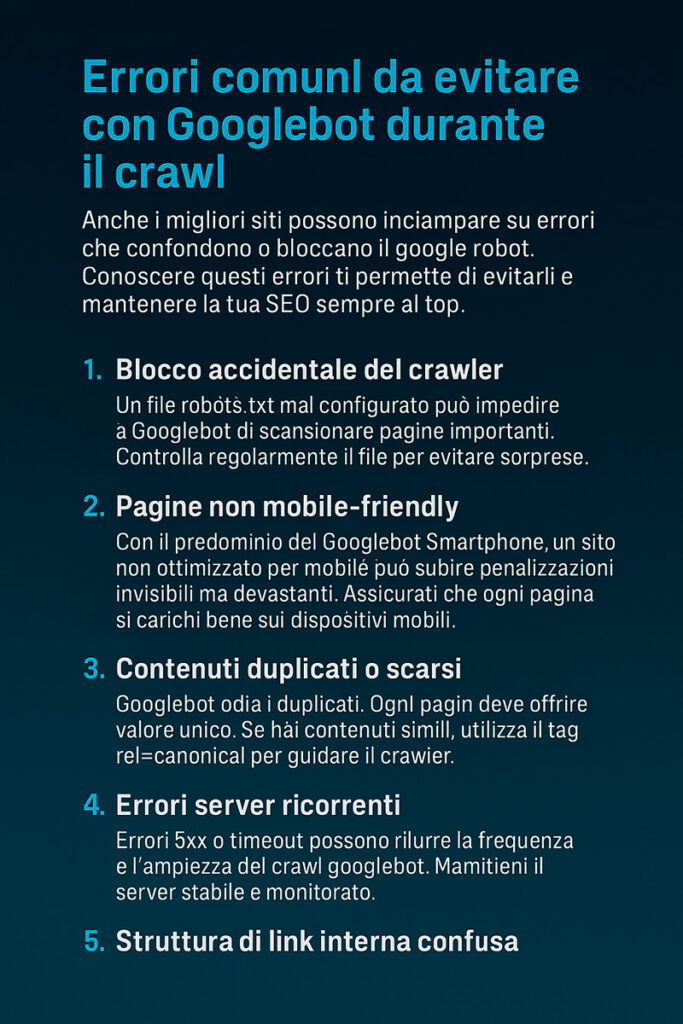

Errori comuni da evitare con Googlebot durante il crawl

Anche i migliori siti possono inciampare su errori che confondono o bloccano il google robot. Conoscere questi errori ti permette di evitarli e mantenere la tua SEO sempre al top.

1. Blocco accidentale del crawler.

Un file robots.txt mal configurato può impedire a Googlebot di scansionare pagine importanti. Controlla regolarmente il file per evitare sorprese.

2. Pagine non mobile-friendly.

Con il predominio del Googlebot Smartphone, un sito non ottimizzato per mobile può subire penalizzazioni invisibili ma devastanti. Assicurati che ogni pagina si carichi bene sui dispositivi mobili.

3. Contenuti duplicati o scarsi.

Googlebot odia i duplicati. Ogni pagina deve offrire valore unico. Se hai contenuti simili, utilizza il tag rel=canonical per guidare il crawler.

4. Errori server ricorrenti.

Errori 5xx o timeout possono ridurre la frequenza e l’ampiezza del crawl googlebot. Mantieni il server stabile e monitorato.

5. Struttura di link interna confusa.

Se Googlebot non trova un percorso logico tra le tue pagine, perderai occasioni preziose di indicizzazione. Costruisci percorsi chiari e gerarchie intuitive.

Per aiutarti a evitare gli errori SEO più comuni che possono compromettere il crawling di Googlebot, ecco una checklist visiva sintetica e pratica.

Ricorda: lavorare bene per Googlebot significa lavorare bene per l’utente.

Se il crawler naviga facilmente il tuo sito, anche i visitatori lo faranno.

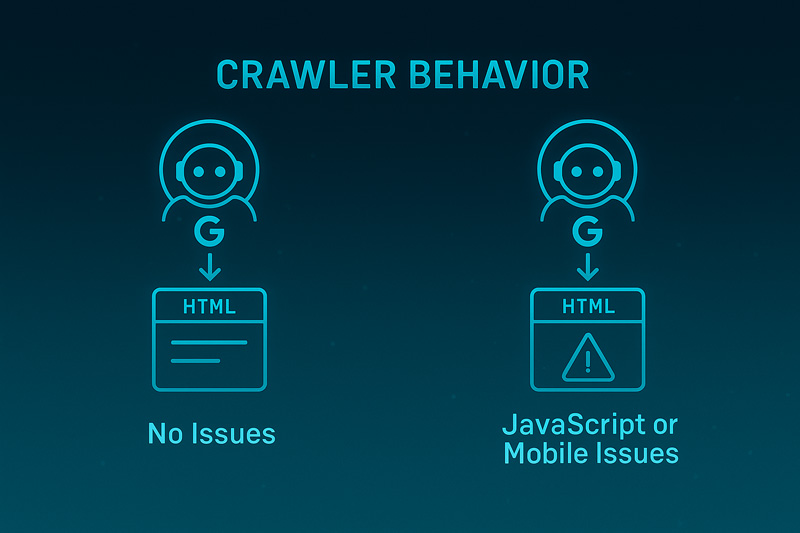

Approfondimenti tecnici: come Googlebot gestisce JavaScript e contenuti dinamici

Negli ultimi anni il web è cambiato radicalmente. I siti sono sempre più dinamici, ricchi di elementi interattivi basati su JavaScript, AJAX e framework moderni. Ma ti sei mai chiesto come Google riesce a scansionare questi contenuti complessi?

Per capire meglio come Googlebot analizza le pagine con o senza problemi JavaScript, osserviamo questa rappresentazione visiva del processo di crawling.

La risposta è semplice e complessa allo stesso tempo: Googlebot oggi è in grado di eseguire il rendering del JavaScript, proprio come farebbe un browser reale. Tuttavia, questo processo non è immediato né privo di insidie. La capacità di interpretare i contenuti dinamici ha rivoluzionato il modo di costruire e ottimizzare un sito.

Quando una pagina utilizza JavaScript pesantemente, Googlebot non si limita a leggere il codice sorgente. Prima scarica il file HTML base, poi invia la pagina a un secondo livello di elaborazione chiamato Web Rendering Service. Solo a quel punto i contenuti generati dinamicamente vengono “visti”.

Questo significa che, se la struttura o la logica di caricamento non sono ottimali, alcuni contenuti potrebbero non essere mai scoperti.

Per questo motivo, progettare i siti pensando anche al google crawler è diventato essenziale.

In sintesi: JavaScript offre possibilità infinite, ma per essere scansionato correttamente, deve essere implementato con intelligenza tecnica.

Il rendering di JavaScript da parte di Googlebot

Quando il crawler di Google visita una pagina basata su JavaScript, avviene un processo in due fasi. Prima, Googlebot effettua il download del codice HTML e delle risorse collegate. Poi, in un momento successivo, passa la pagina a un sistema di rendering interno che simula l’apertura in un browser.

Questo significa che i contenuti generati dinamicamente possono non essere subito disponibili al momento della prima scansione.

Per alcuni siti, questa differenza di timing può causare ritardi di giorni o settimane prima che i contenuti vengano effettivamente indicizzati.

Un problema comune è quello delle Single Page Application (SPA), dove gran parte del contenuto viene caricato dopo l’interazione dell’utente. Se il sito non fornisce fallback adeguati o prerendering, Googlebot potrebbe vedere solo una pagina vuota o parzialmente caricata.

Soluzione pratica: usare tecniche come Server Side Rendering (SSR), Dynamic Rendering o strumenti come prerender.io per assicurarti che i contenuti chiave siano subito disponibili anche senza esecuzioni client-side.

In breve, non basta che il tuo sito funzioni bene per gli utenti: deve funzionare bene anche per chi lo scansiona.

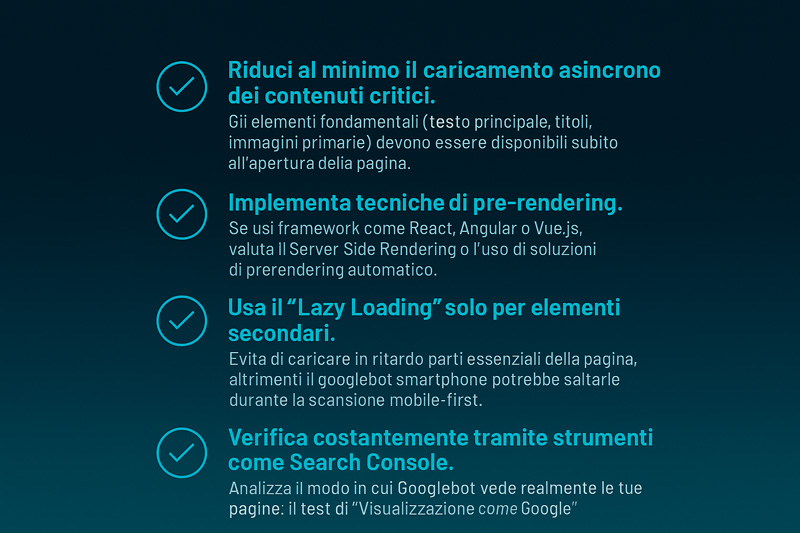

Best practices per migliorare il caricamento dinamico dei contenuti

Se vuoi che il tuo sito sia pienamente visibile agli occhi dei motori di ricerca, ci sono alcune pratiche indispensabili da seguire.

1. Riduci al minimo il caricamento asincrono dei contenuti critici.

Gli elementi fondamentali (testo principale, titoli, immagini primarie) devono essere disponibili subito all’apertura della pagina.

2. Implementa tecniche di pre-rendering.

Se usi framework come React, Angular o Vue.js, valuta il Server Side Rendering o l’uso di soluzioni di prerendering automatico.

3. Usa il “Lazy Loading” solo per elementi secondari.

Evita di caricare in ritardo parti essenziali della pagina, altrimenti il googlebot smartphone potrebbe saltarle durante la scansione mobile-first.

4. Verifica costantemente tramite strumenti come Search Console.

Analizza il modo in cui Googlebot vede realmente le tue pagine: il test di “Visualizzazione come Google” è il miglior amico del tuo sito.

Per fissare rapidamente le principali strategie di ottimizzazione tecnica a beneficio del crawling di Googlebot, ecco una checklist visiva riepilogativa.

Seguendo queste regole, assicurerai a Google una visione completa e corretta del tuo sito, indipendentemente dalla complessità del frontend.

Il futuro è dinamico, ma la chiarezza resta la tua alleata numero uno.

Strumenti utili per monitorare e analizzare l’attività di Googlebot

Capire cosa fa il crawler di Google quando visita il tuo sito è essenziale per ottimizzare ogni aspetto della SEO. Non puoi migliorare ciò che non misuri. Ecco perché esistono strumenti potenti che ti aiutano a monitorare ogni movimento del google crawler.

Il primo alleato da conoscere è senza dubbio Google Search Console. Questo strumento gratuito ti permette di vedere quali URL sono stati scansionati, quali errori ha incontrato il bot e se ci sono problemi di indicizzazione.

Ma non basta fermarsi a Search Console. Esistono anche strumenti di terze parti come Screaming Frog SEO Spider, Ahrefs Site Audit e Lumar che permettono di simulare il comportamento di un robot google e trovare criticità non immediatamente visibili.

Utilizzando queste piattaforme, puoi ottenere insights su:

- Pagine bloccate da robots.txt.

- Errori 404 o server error.

- Contenuti duplicati o pagine orfane.

Un’analisi regolare ti permette di mantenere il sito sano agli occhi dei crawler google, aumentando le probabilità di essere indicizzato in modo completo ed efficace.

In poche parole, il monitoraggio costante è la chiave per anticipare i problemi e trasformare ogni scansione in un’opportunità di crescita.

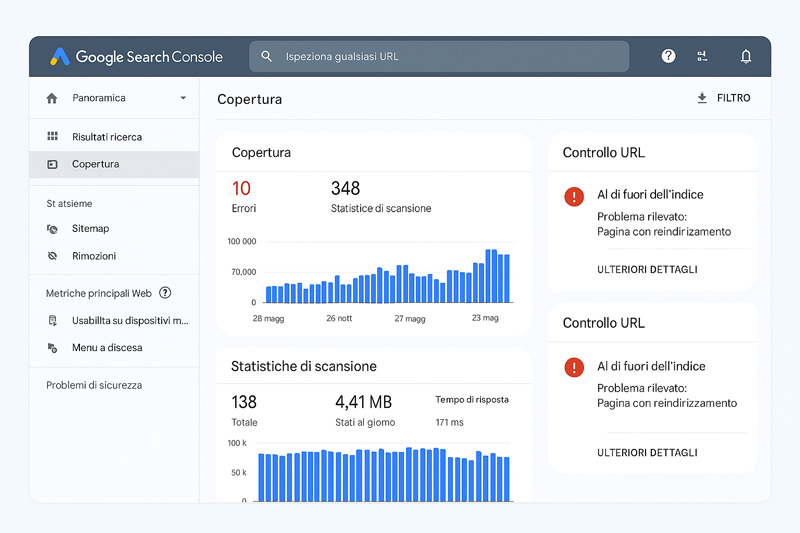

Come utilizzare Google Search Console per vedere il comportamento di Googlebot

Google Search Console è il punto di partenza ideale per analizzare l’interazione tra il tuo sito e il crawler di Mountain View. Dopo aver verificato il tuo sito nella piattaforma, accedi alla sezione “Controllo URL”: qui puoi inserire qualsiasi pagina e vedere come è stata scansionata.

Uno degli strumenti più utili è “Visualizza come Google”. Ti mostra esattamente quello che il bot ha visto, evidenziando eventuali problemi di caricamento o accessibilità.

All’interno della sezione “Copertura”, invece, puoi analizzare:

- Pagine valide indicizzate.

- Pagine escluse e motivi di esclusione.

- Errori critici che bloccano il crawl googlebot.

Vediamo ora come si presenta visivamente la gestione dei dati di crawling e indicizzazione nella Google Search Console.

- Pagine bloccate da robots.txt.

- Errori 404 o server error.

- Contenuti duplicati o pagine orfane.

Search Console ti segnala anche se il sito ha problemi di usabilità mobile, elemento cruciale per il corretto funzionamento del googlebot smartphone.

Controllare regolarmente questi report ti permette di mantenere il controllo sulla salute SEO del sito, evitando spiacevoli sorprese nei risultati di ricerca.

In breve, Search Console non è solo un tool: è la finestra ufficiale sul mondo dei crawler Google.

Altri strumenti SEO per tracciare Googlebot e ottimizzare il crawl

Sebbene Search Console offra informazioni preziose, a volte serve qualcosa di ancora più dettagliato. E qui entrano in gioco gli strumenti avanzati di crawling e audit SEO.

Screaming Frog SEO Spider è uno dei più potenti: simula l’attività di un google crawler e ti permette di vedere esattamente come il bot attraversa il tuo sito. Utile per individuare errori strutturali, link rotti, problemi di canonicalizzazione.

Ahrefs Site Audit e Lumar sono altre due piattaforme eccellenti. Analizzano la profondità dei click, la struttura dei link interni, i problemi di robots.txt e sitemap XML. Inoltre, offrono insight su come migliorare il crawl budget e aumentare l’efficienza della scansione.

Un altro strumento molto utile è il log file analysis: analizzando i file di log del server, puoi vedere realmente ogni visita di bot google al tuo sito, capire quali pagine vengono più frequentemente scansionate e individuare eventuali pattern problematici.

Un approccio combinato tra Search Console e strumenti esterni ti garantisce una visione completa e dettagliata del rapporto tra il tuo sito e i crawler di Google.

In conclusione, monitorare e ottimizzare l’attività di Googlebot non è mai stato così accessibile.

Basta usare gli strumenti giusti e agire con costanza.

Errori SEO da evitare con Googlebot: come non compromettere il crawling

Quando si parla di ottimizzazione per i motori di ricerca, è facile concentrarsi su cosa fare. Molto meno attenzione si dà, invece, a cosa evitare. Eppure, certi errori SEO possono bloccare o confondere i crawler di Google, compromettendo gravemente la visibilità del sito.

Uno dei problemi più gravi è limitare l’accesso ai contenuti importanti. File robots.txt mal configurati, meta tag noindex posizionati male o pagine protette da login possono impedire a strumenti come il google crawler di scansionare le aree vitali del sito.

Un altro errore classico è ignorare la velocità di caricamento. I bot, inclusi i google robots, preferiscono siti rapidi. Ogni secondo di ritardo aumenta il rischio che alcune pagine vengano ignorate durante il crawling.

Attenzione anche alla struttura interna dei link. Se il sito presenta link rotti, loop infiniti o un’architettura caotica, i bot potrebbero non riuscire a navigarlo correttamente. Un percorso chiaro aiuta non solo gli utenti, ma anche chi esplora il sito automaticamente.

Contenuti duplicati e errori server sono altre due trappole comuni. Gli errori 5xx ripetuti e la presenza massiccia di duplicati compromettono il crawl budget e riducono la fiducia del crawler nel tuo dominio.

In sintesi, non basta creare contenuti eccellenti: bisogna costruire un ambiente tecnico sano, dove ogni visita del bot sia fluida ed efficiente. Evitare questi errori ti permetterà di capitalizzare davvero ogni opportunità di visibilità.

Per visualizzare rapidamente i principali elementi che favoriscono il corretto comportamento di Googlebot, osserviamo questa mappa mentale dei fattori di ottimizzazione SEO.

Blocchi accidentali, errori tecnici e segnali negativi: cosa confonde Googlebot

Anche un piccolo errore tecnico può mandare in confusione il crawler di Google. Vediamo quali sono i più comuni e come evitarli.

1. Robots.txt troppo restrittivo.

Bloccare intere sezioni del sito senza accorgersene è uno degli errori più devastanti. Controlla regolarmente cosa stai effettivamente impedendo di scansionare.

2. Tag noindex errati.

Inseriti su pagine che dovrebbero invece essere indicizzate, i meta noindex impediscono la visibilità organica anche di contenuti strategici.

3. Redirect mal configurati.

Loop di redirect o catene troppo lunghe rallentano il crawling e possono persino impedire il corretto completamento della scansione.

4. Errori server non gestiti.

Un server instabile o errori 5xx frequenti riducono la fiducia che il google crawler ripone nel tuo dominio. Monitorare la stabilità è essenziale.

5. Assenza di mobile optimization.

Con il predominio del googlebot smartphone, la mancanza di una versione mobile-friendly è un errore SEO che non puoi permetterti.

Evitare questi problemi ti consente di mantenere una relazione sana e produttiva con i crawler google, garantendo al tuo sito ogni possibilità di successo organico.

Come prevenire problemi di indicizzazione e ottimizzare il rapporto con il crawler di Google

Prevenire è meglio che curare, anche nel mondo del SEO tecnico. Mantenere un ambiente favorevole per il crawler ti garantisce risultati stabili e duraturi.

1. Revisiona regolarmente il file robots.txt e le direttive meta.

Non lasciare nulla al caso: controlla se stai accidentalmente bloccando risorse vitali.

2. Sfrutta la Search Console per monitorare il crawl.

La sezione “Copertura” ti mostra subito eventuali problemi di accesso o indicizzazione. Non aspettare che un problema tecnico si trasformi in un crollo di traffico.

3. Cura la velocità e la stabilità del sito.

I tempi di caricamento e l’affidabilità server sono fondamentali per favorire il lavoro dei google robots.

4. Ottimizza la versione mobile.

Con il mobile-first indexing attivo, ogni errore su mobile pesa il doppio sulla SEO generale.

5. Prepara sitemap aggiornate e ben strutturate.

Una sitemap pulita aiuta i bot google a esplorare meglio il sito, garantendo che ogni sezione importante venga scoperta rapidamente.

Seguire queste pratiche ti permette non solo di prevenire problemi, ma anche di ottimizzare proattivamente ogni visita del crawler.

In definitiva, curare la relazione tecnica con il bot è uno dei pilastri della SEO moderna.

Chi se ne dimentica, lascia il campo libero alla concorrenza.

Conclusione: il rapporto tra il tuo sito e Googlebot è la chiave del successo SEO

A questo punto, è chiaro: l’interazione tra il tuo sito e i crawler di Google è uno dei pilastri fondamentali su cui si gioca il successo nella ricerca organica. Capire come i bot esplorano, interpretano e valutano i tuoi contenuti ti offre un vantaggio competitivo reale.

Non basta creare contenuti di qualità. Devi costruire un ambiente tecnico che favorisca il crawling efficace, risolvendo errori che ostacolano il passaggio del google crawler e migliorando ogni aspetto dell’accessibilità. Dalla velocità di caricamento alla struttura dei link, dal mobile-first all’uso intelligente di robots.txt: ogni dettaglio conta.

Abbiamo visto quanto sia importante:

- Facilitare l’accesso con sitemap aggiornate e chiare.

- Evitare blocchi accidentali e errori server che riducono la fiducia del crawler google.

- Rendere la versione mobile del sito impeccabile, per assecondare il comportamento del googlebot smartphone.

- Fornire contenuti dinamici accessibili, anche se realizzati in JavaScript.

Sfruttando strumenti come Google Search Console, Screaming Frog o le analisi dei file di log, puoi monitorare il comportamento dei google robots e intervenire in modo tempestivo ogni volta che qualcosa non funziona come dovrebbe. Essere proattivi è la vera chiave del successo SEO moderno.

Il rapporto con il crawler non è statico: si costruisce e si perfeziona nel tempo. Ogni miglioramento tecnico, ogni ottimizzazione strutturale, ogni aggiornamento che favorisce la scansione è un investimento diretto sulla tua visibilità online.

In definitiva, Googlebot non è un nemico da temere, ma un alleato da comprendere.

Se aiuti il bot a vedere e capire il meglio del tuo sito, Google premierà i tuoi sforzi con una presenza più forte, più stabile e più redditizia nei risultati di ricerca.

Investi nel dialogo invisibile con il crawler di Google e costruirai basi solide per il tuo successo digitale.

Domande frequenti su Googlebot, crawling e indicizzazione: tutto quello che devi sapere

Come posso verificare se un crawler è realmente Googlebot?

Puoi verificare se un crawler è Googlebot controllando il suo indirizzo IP tramite reverse DNS lookup e confrontandolo con i range IP ufficiali pubblicati da Google.

Qual è la differenza tra Googlebot Desktop e Googlebot Smartphone?

Googlebot Desktop simula la navigazione da computer, mentre Googlebot Smartphone simula la navigazione da dispositivi mobili e viene usato prioritariamente per l’indicizzazione.

Come influisce il file robots.txt sull’attività di Googlebot?

Il file robots.txt comunica a Googlebot quali sezioni del sito può scansionare e quali no, influenzando direttamente il crawling e l’indicizzazione.

È possibile controllare la frequenza di scansione di Googlebot?

Non è più possibile impostare manualmente la frequenza di scansione tramite Search Console. Puoi solo influenzarla indirettamente gestendo il carico server o inviando richieste speciali a Google.

Come gestisce Googlebot i contenuti dinamici generati da JavaScript?

Googlebot esegue il rendering del JavaScript in una fase successiva alla scansione iniziale, il che può causare ritardi nell’indicizzazione dei contenuti dinamici.

Cosa significa l’errore “Indicizzata ma bloccata da robots.txt” in Google Search Console?

L’errore indica che la pagina è conosciuta da Google ma non può essere scansionata direttamente a causa delle restrizioni imposte dal file robots.txt.